卷积神经网络(Convolutional neural networks ,CNNs)是当前深度学习基础的模型。由他改进衍生处的众多深度学习模型在图像分类,图像超分辨率重建,图像分割等众多方面有着许多应用。而梯度下降法 (Gradient descent optimization, GD) 是CNN模型优化的基本算法。自GD出现以来,已有一系列改进的算法问世。在这些算法中,自适应矩估计(Adaptive moment estimation,Adam)作为梯度下降法的一种优化算法,由于其优化收敛速度快,训练得到的模型准确率高而得到了广泛的认可。但是深入剖析Adam算法发现,Adam算法中局部的变化信息在一定程度上被忽略了。

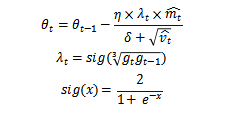

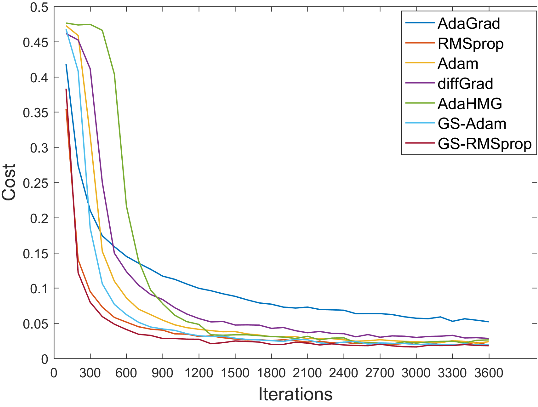

我们在Adam算法的基础上引入了一个基于当前梯度和最近梯度的自适应学习速率因子。通过这个自适应学习速率因子,我们可以动态地调整每个独立参数的学习率来进行自适应调整。该算法是对现有梯度下降算法的补充,可以与其他许多现有的改进型梯度下降算法相结合,提高模型效率以及最后完成的模型的性能。

研究已证明该方法在图像分类的CNN网络中具有更好的性能。相关论文已在期刊Computational Intelligence and Neuroscience上在线发表(链接:https://doi.org/10.1155/2021/6671830)我院18级硕士研究生刘志鹏为第一作者,南京医科大学生物医学工程与信息学院的吴小玲和王伟老师为共同通讯作者,南京医科大学为第一署名单位。

我院吴小玲教授团队致力于人工智能在医学方面的应用,研究内容包括磁共振图像的超分辨率重建,磁共振图像去伪影,膝关节骨关节炎自动分期等。